作为商业分析师,或多或少听过机器学习。你每天都在用它的产品,比如"猜你喜欢"、"预估配送时间"、"智能客服"等都是机器学习的具体应用。

今天我们就来聊聊最常用的三大类算法,以及使用机器学习时的两个关键注意事项。

不用担心,我会用最接地气的方式,让你轻松理解这些概念。

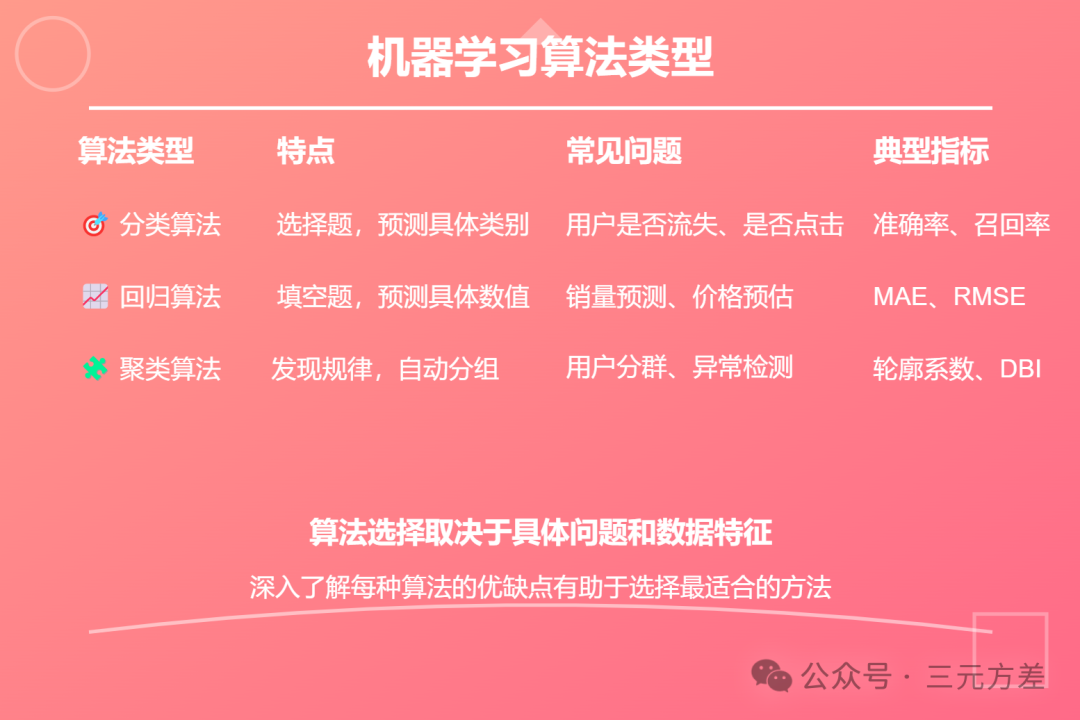

一、三大类机器学习算法1. 分类算法:预测"是或否"

想象一下,你是音乐APP的产品经理,每天面对海量的音乐数据,如何精准预测用户会喜欢哪些歌?

这就是一个典型的分类问题。

分类算法就像一个"是非题",它的答案永远是确定的选项,比如"会喜欢/不会喜欢","是/否","A/B/C"等。

最常用的分类算法有:

决策树:就像是玩20个问题的游戏。比如:这首歌的风格是民谣吗?用户最近听过这个歌手的歌吗?用户是否经常在晚上听这类音乐?通过一系列问题,最终得出"用户可能会喜欢这首歌"的结论。决策树的优势在于可解释性强,你可以清晰地看到每个决策的依据。

随机森林:这个听起来很高大上,其实就是找100个人(100棵决策树)一起决策,少数服从多数。每个决策树都独立判断,互不干扰,最后投票决定。这样做的好处是,能够避免单个决策树的偏见,提高预测准确性。就像在公司做决策,集思广益总比一个人拍板要靠谱。

在商业分析中,分类算法的应用无处不在:

预测用户流失:通过分析用户的使用频率、最近登录时间、消费金额变化等特征,预测哪些用户可能会流失。这样我们就能提前对这些用户进行针对性的营销挽留。

欺诈检测:在金融领域,通过分析交易时间、金额、频率、地点等特征,判断一笔交易是否可能是欺诈。

商品推荐:结合用户的历史浏览、购买记录,以及商品的类别、价格等信息,预测用户是否会对某个商品感兴趣。

举个实际的例子:某电商平台想预测用户是否会在未来30天内购买某个商品。他们可能会考虑这些特征:

用户最近30天的浏览次数

用户是否将商品加入购物车

用户历史购买同类商品的频率

用户的客单价水平

商品的折扣力度

商品的库存状态

用户是否是会员

通过训练分类模型,就能得到一个预测结果:"该用户有87%的概率会在未来30天内购买这个商品"。

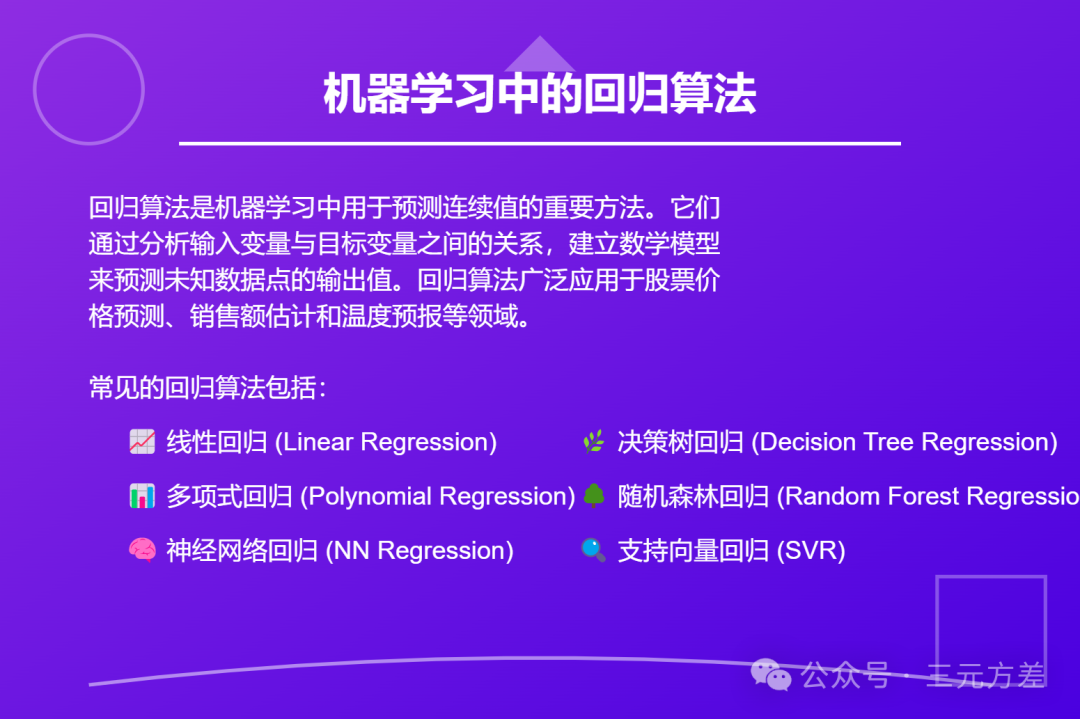

2. 回归算法:预测具体数值

如果说分类算法是选择题,那回归算法就是填空题。你在使用滴滴打车的时候,你叫车前,它就能估算出价格。这就是回归算法在发挥作用。回归算法的特点是预测连续的数值,而不是离散的类别。

常见的回归算法包括:

线性回归:这是最基础的回归算法,假设特征和预测值之间存在线性关系。想象你坐公交车,每公里2元,这就是最简单的线性关系。在实际应用中,可能会考虑多个特征,比如预测房价时,不仅要考虑面积(每平米单价),还要考虑地段、楼层、装修等因素。

GBDT(梯度提升决策树):这个名字听起来吓人,但实际很好理解。就像打高尔夫,第一杆打偏了,第二杆调整一点,第三杆再调整一点,每次都在纠正之前的误差,最终找到最好的路径。GBDT在工业界非常受欢迎,因为它能自动挖掘特征间的非线性关系,预测效果往往比线性回归好得多。

商业分析中的应用场景:

销量预测:预测未来一段时间内的商品销量,这对于库存管理和供应链优化至关重要。

广告点击率预测:在投放广告前,预估可能的点击率,这直接关系到广告位的定价和排序。

客户终身价值预测:预测一个客户在未来可能贡献的总收入,这对于制定差异化的客户服务策略非常重要。

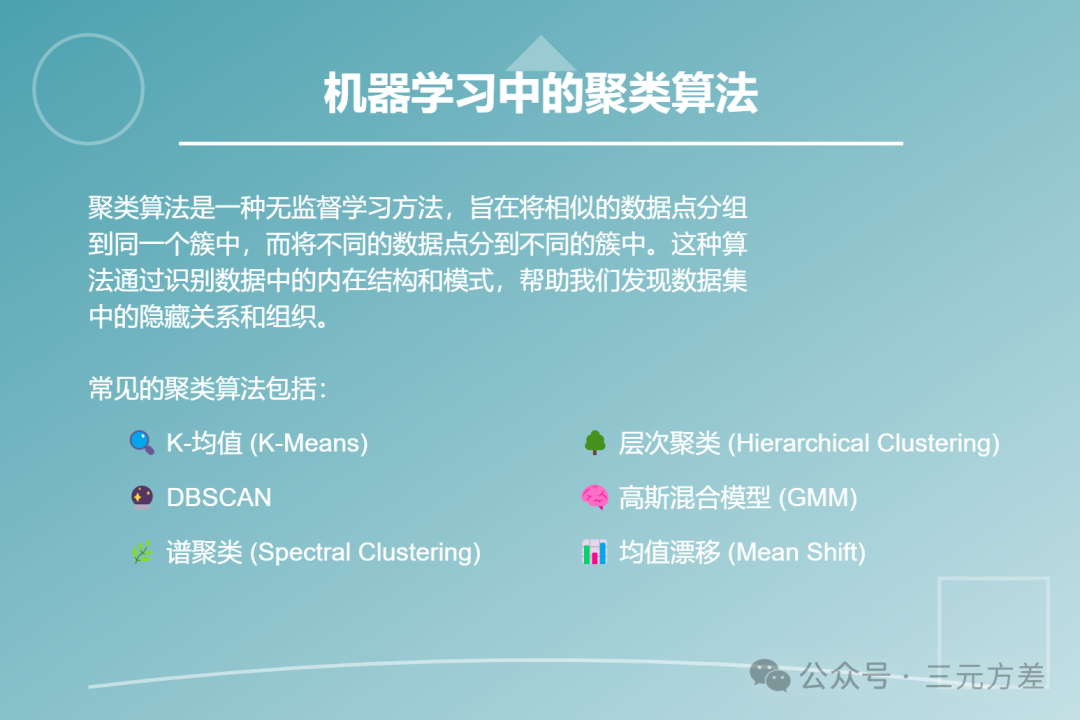

3. 聚类算法:发现相似的群体

聚类算法就像是一个优秀的运营,能把相似的用户分到一组。用户运营就经常用聚类算法来发现不同的用户群体,这样就能精准推送内容了。与分类算法不同,聚类算法不需要预先知道分组的标准,它能自动发现数据中的模式。

两个常用的聚类算法:

K-Means:就像给羊分圈,先定好要分几个圈(K值),然后看哪只羊离哪个圈最近。这个过程会不断重复,直到每只羊都找到最合适的圈。K-Means的优点是简单高效,缺点是需要预先指定K值,而且对异常值比较敏感。

DBSCAN:这个更智能,它会自动发现人群密集的地方,就像在音乐节上发现不同的粉丝团。DBSCAN不需要预先指定分组数量,而是根据数据的密度自动划分,还能识别出异常点。缺点是对参数的设置比较敏感,需要一定的经验。

关于各类算法的特点,我总结了下面的表:

1. 所有模型都是错的,但有些是有用的

所有模型都是错的,但有些是有用的。

这句话不是我说的,是统计学家George Box说的。它告诉我们:不要追求完美的模型,要追求有用的模型。在商业分析中,这一点尤其重要。

假设有一位学生为了准备考试。

这个学生在复习时,只是简单地浏览了一下去年的考试内容,既没有记住题目,也没有深入理解知识点。他既没有对去年的题目产生深刻的理解,也没有掌握应对新题型的方法。

因此,当他面对去年的试卷时,错的很多;而到了正式考试,他依然没有足够的知识来应对这些新的问题。

在机器学习中,这种情况就是欠拟合。

欠拟合的模型就像这个没有深入学习的学生——模型过于简单,没有足够的能力去捕捉数据中的重要模式和规律,所以它在训练数据和测试数据上都表现不好。

如果他拿到了去年的考试卷子,并且把每一道题的答案都背得滚瓜烂熟。这种情况下,学生在做和去年的试卷一模一样的题目时,可能表现得非常好,分数很高。这就像模型在训练数据上表现非常好一样。

但是,到了正式考试时,考卷上的题目和去年的不完全一样,虽然有些题型类似,但题目细节发生了变化。由于学生只会死记硬背去年的答案,而没有真正理解知识,他在新的考题上可能表现得很差。这个学生在应对训练数据(去年的试卷)时表现得很好,但在测试数据(正式考试卷)上却失败了。

这就是过拟合。过拟合是指模型过于专注于训练数据中的细节和噪声,无法很好地应对新数据。

过拟合和欠拟合的平衡是很微妙的,真正能用的模型既不能欠拟合也不能过拟合。

那么如果两个模型效果差不多,怎么办?这种情况要遵循一个原则:奥卡姆剃刀。

意思是,如果两个模型效果差不多,那就选择更简单的那个。这就像你背单词,与其背一大堆近义词,不如先把最常用的掌握好。在实际工作中,我们经常会看到:

简单的决策树模型,可解释性强,同事容易理解

线性回归虽然简单,但在很多场景下效果足够好

复杂的深度学习模型,可能会过拟合,导致线上效果不稳定

2. 选对评估标准,避免南辕北辙

评估标准就像是考试的评分标准,选对了,才能评判模型的好坏。不同的业务场景,关注的重点不同,使用的评估标准也应该不同。

拿广告点击预测来说,我们经常用这些指标:

准确率(Precision):预测点击的广告中,真正被点击的比例

召回率(Recall):所有被点击的广告中,被正确预测的比例

F1分数:准确率和召回率的调和平均数,平衡两者的取舍

选择哪个指标?要看你的目标:

如果预算有限,追求精准,就看准确率

如果怕错过机会,宁可多投,就看召回率

如果两者都想兼顾,可以看F1分数

预测情况 | 实际点击 | 实际不点击 |

预测点击 | 真正例(TP) | 假正例(FP) |

预测不点击 | 假负例(FN) | 真负例(TN) |

准确率 = TP / (TP + FP)

召回率 = TP / (TP + FN)

F1 = 2 * (准确率 * 召回率) / (准确率 + 召回率)

在实际工作中,选择评估指标时需要注意:

考虑业务成本:有时候假正例和假负例的成本不一样,比如在欺诈检测中,把正常交易判断为欺诈(假正例)的成本,可能远小于把欺诈交易判断为正常(假负例)的成本

数据不平衡:在用户流失预测中,流失用户往往是少数,这时候准确率可能会产生误导,应该更关注召回率

综合多个指标:不要只看单个指标,应该综合考虑多个指标,全面评估模型性能

现在一般商业分析师不太自己做机器学习的分析,而是交给算法工程师。

不过学习机器学习,就像学开车。你不需要知道发动机的每个零件,但要知道什么时候该用什么档位。作为商业分析师,你需要掌握这些基础概念,就能遇到合适的问题的时候,想起可以用机器学习解决这类问题。

·END·

看完觉得写得好的,不防打赏一元,以支持蓝海情报网揭秘更多好的项目。