2024年的大模型故事,依旧热闹非凡。

大洋彼岸外,从Sora的横空出世到Llama 3再度掀起的开源 vs 闭源之争,再到各类集成大模型能力的AI硬件......在通往AGI的征途上,为了让大模型落地,海外科技巨头靠着scaling laws(规模定律),并没有停下脚步。

不久前,OpenAI创始人Sam Altman就在演讲中表示:scaling laws依旧有效,GPT-5将比GPT-4聪明得多,我们还没有到达这条曲线的顶端。

scaling laws是一条OpenAI验证过的道路,通过堆算力、卷参数,提升大模型能力,进而抵达真正的通用人工智能阶段。

但回到国内大模型行业,scaling laws所面临的一个现实难题不仅是以芯片为代表的国内外产业链基础的差距,更关键的一个问题是:

如何去发挥从移动互联网时期中国技术企业的场景和应用优势,在堆参数之外,找到让模型高效落地于行业应用的路径,将实验室里的模型能力转化为看得见的应用价值?

在这一问题上,作为国内大模型行业头部梯队的科大讯飞,已率先找到了一条新路。

01.拼底座,破解技术焦虑的正确姿势

回到轰轰烈烈的大模型热潮,随模型参数量和数据集的增长,大模型的能力边界进而拓展与迭代,这无疑是scaling laws给国内AI玩家们所带来的关键启示。

在行业过去残酷的百模大战里,尽管国内涌现出诸多行业模型和垂直应用,但如果提及国内大模型玩家的焦虑,排在第一依旧是技术底座上的难关,这包含两个核心问题:一是算力够不够用、好不好用?二是对标OpenAI的GPT-4/4V乃至未来的GPT-5等底座基础模型,国内通用大模型能力能否不断缩小差距?

在算力层,据李飞飞的估算,最新一代人工智能模型的训练成本已达到前所未有的水平。比如,OpenAI的GPT-4预计使用了价值7800万美元的计算资源进行训练,而谷歌的Gemini Ultra则耗费了接近2亿美元的计算资源成本。

回到国内,受地缘政治影响,在美国对华芯片制裁的外部压力下,国内大模型玩家不可避免地面临算力稀缺等问题。同时,大卷算力所带来的高昂算力成本,也抬高了大模型落地的门槛,算力太贵也是一大现实难题。

缓解大模型落地的算力焦虑,上到国家政策支持,下到企业布局,均在行动。不久前,北京市发布《北京市算力基础设施建设实施方案(2024—2027 年)》,明确指出,将大力推动人工智能大模型与自主可控芯片开展适配,提升我国智能算力产业供应链的安全性、稳定性和坚韧性。

作为中国人工智能的国家队,科大讯飞给出的思路是,打造国产化自主可控的算力底座,为大模型行业提供新的算力选择。为此,科大讯飞同华为强强联手,在算力底座上合力打造出了首个万卡规模的国产算力平台飞星一号,华为的硬件能力结合科大讯飞的AI技术沉淀,一个自主可控的算力底座为国内大模型生态注入了新的活力。

在此基础上,底层模型能力的竞赛也在同步进行,国内外科技巨头都在加速追赶与超越GPT-4,对通用模型能力进行迭代。

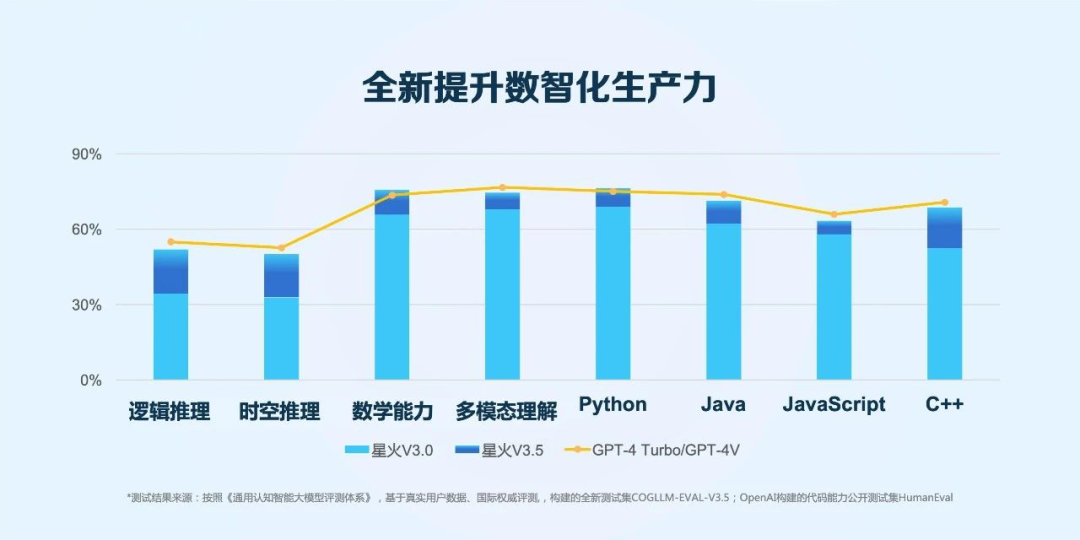

在国内大模型玩家中,科大讯飞为数不多对外公布其模型迭代具体时间表的科技企业。今年1月30日,科大讯飞发布的讯飞星火V3.5,在逻辑推理、语言理解、文本生成、数学答题、代码、多模态各个能力方面均实现大幅提升,整体性能已接近GPT-4 Turbo。

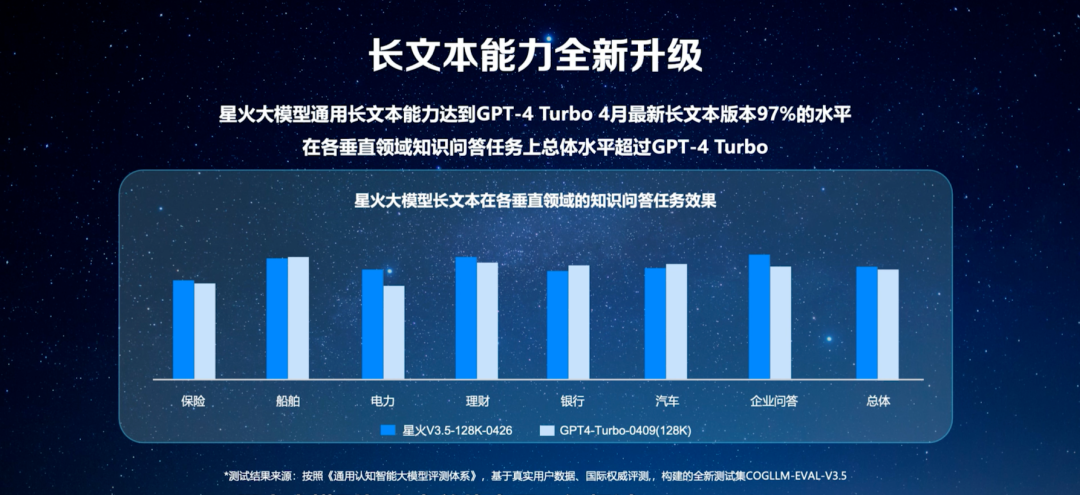

不久前,科大讯飞又宣布了V3.5版本的能力更新,聚焦用户高效知识获取的长文本、长图文和长语音功能。以如今已成为大模型标配的长文本为例,目前星火大模型的通用长文本能力总体已达到GPT-4 Turbo,且在多个垂直领域的知识问答任务上,星火大模型长文本总体水平已超过GPT-4 Turbo。

一个行业共识是,随着模型技术的收敛与行业竞争格局的演变,2024年,大模型的竞争焦点依旧落在通用大模型能力上。一方面,通用大模型的能力优劣决定中国大模型产业能否掌握自己的核心话语权;另一方面,唯有底层通用大模型能力持续提升,追赶国际最先进水平,行业大模型才能有更好的成效。

围绕算力和通用模型上的持续加码,这是夯实技术底座的必由之路,也是破解技术焦虑的正确姿势。这也意味着,围绕技术底座的研发投入,也决定着国产模型厂商的未来身位。

科大讯飞在研发投入上有自己清晰的节奏和策略。在近期公司业绩说明会上,科大讯飞董事长刘庆峰透露,2023年,科大讯飞基础大模型研发和行业应用研发中的比例约为7:3,今年,依旧会把50%的研发投入用于大模型底座能力上。刘庆峰预测:中美之间的底座模型能力还存在半年到一年的动态追赶过程,但中国是唯一不会被彻底甩开的国家,科大讯飞作为中国的国家队正在持续缩小与美国同行的差距。

02.拼落地,科大讯飞的云、边、端之道

在scaling laws给大模型玩家们带来的卷技术底座启示外,眼下,告别火热吸睛参数等性感概念,大模型的竞争已进入到下一赛点——无论是做应用,还是抢客户,关注的重点都放在了模型落地和应用的广度与深度上。

海外如微软、谷歌等科技巨头,不仅已加速将大模型能力集成已有产品矩阵中,同时也与诸多行业头部客户开展AIGC领域全方位的合作。

客观来说,在大模型如何落地这一问题上,行业至今未能有人给出完美的范本答案。背后原因有两点:一是从供需两端看,由于大模型技术发展依旧属于早期阶段,需求方对自身业务落地大模型的需求和价值还在摸索,而作为供给方的模型厂商也在通过供给创新找到落地的范式。二是大模型技术是一种生产力,落地产业就需要建立起供需两端的循环体系,各参与方都要有利可图,比如行业和产业端需要的是更有性价比的大模型,而模型厂商同样需要借助大模型实现变现。

大模型如何卷落地?科大讯飞给出的解题思路是——从现实的场景需求出发,云、边、端一体化、全场景布局,来满足各个复杂多元场景对大模型的需求。

在云侧,科大讯飞在开始大模型技术攻关时就确立了1+N的大模型体系,在基础通用大模型外,同步面向各个行业落地行业大模型与产品应用,比如教育大模型、医疗大模型,同时携手金融、能源、汽车、通信、化工等领域龙头企业共同打造行业大模型。

于此同时,面向开发者,除了开放API和RAG、Agent等大模型配套能力方案,也开源了讯飞星火-13B模型,支持行业进行场景化定制微调。在过去不到3个月的时间里,科大讯飞就新增了55万实名认证的开发者,其中一半以上的应用服务落地于企业刚需场景。

讯飞星火APP也在获得越来越多用户的认可。据七麦数据显示,讯飞星火APP在安卓端的下载量已经超过9600万次,在国内工具类通用大模型APP中排名第一。

在边侧,针对企业的私有化部署需求,科大讯飞与华为联手打造的讯飞星火一体机可针对企业的高频场景应用需求,提供开箱即用的大模型一体化解决方案,目前已落地城市、金融、运营商、制造、能源、汽车等诸多行业场景。

在端侧,科大讯飞一方面将大模型能力落地学习机、翻译机、办公本等自有智能硬件,另一方面,将大模型的能力深度赋能行业,正在落地汽车、家电、机器人、AI手机、AI PC等领域,在人们触手可及的终端产品上,带来体验的升级。

比如,汽车场景中,通过端侧小模型+云侧大模型协同,既能够解决用户在无网弱网环境下的交互,还能更好地保护隐私,对于简单问题直接在本地端解决,复杂问题在云端解决,既能给用户带来很好的体验,也能够有效降低成本。

云、边、端布局带来的利好是双重的。

首先,开年以来,为大模型技术能力找到最佳的入口与载体,已成为业内共识,三剑齐发能更大范围内释放大模型的落地价值,将大模型引向一条实用的路径。其次,对科大讯飞而言,云、边、端协同可以更好地满足各种场景中的应用需求,不同尺寸的模型组合使用,成本更低、效率更高,为其商业化提供了更多的通路。无论是大模型赋能的智能硬件销量表现,还是开发者的快速增长,都显示科大讯飞走在商业化的前列。

不过,云、边、端的布局并非人人可做,人人能做。

科大讯飞的优势在于从后端技术到前端应用场景的系统化能力。在后端技术层,一方面是基于国产自主可控软硬件底座所打造出的不断迭代的星火通用大模型,另一方面,是科大讯飞从模型、框架、工具和应用层的全栈技术布局。

在前端应用场景上,科大讯飞凭借过硬的工程化能力,在效果接近无损的情况下,让模型尺寸具备七十二变的能力,从而实现大模型地高效部署。

据了解,科大讯飞面向不同场景和硬件平台, 提供从面向云端百B级、十B级到面向端侧硬件的B级模型,覆盖云+端各类场景和应用,以此满足各行业复杂场景模型需求。

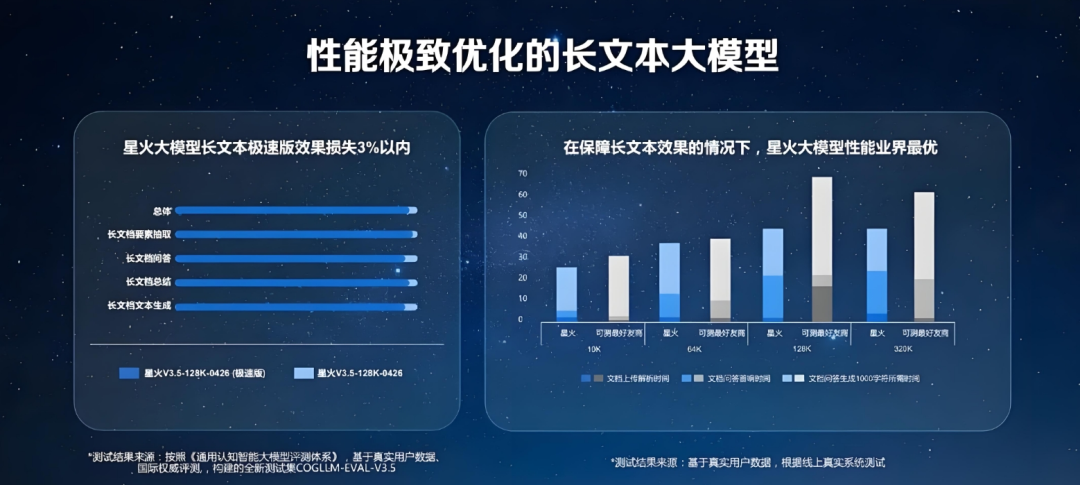

此前科大讯飞推出13B长文本大模型就是一个例子。在大模型厂商集体卷长文本的时代,与动辄千亿参数的大模型相比,科大讯飞通过对模型尺寸的剪枝和蒸馏,从小搏大,推出了业界性能最优的130亿参数的大模型,在效果损失仅3%以内的情况下,星火在文档上传、解析处理、知识问答的首次响应时间和文字生成方面都有了极大的效率提升。

云、边、端的全场景布局,从后端技术到前端应用的互相支撑,既延伸了模型落地的广度,科大讯飞为大模型落地找到了更多的场景,也拓展了模型落地的深度,行业积累的数据、knowhow能进一步反哺模型能力的迭代,这是一个更健康的循环。

03.拼价值,少有的技术务实派

在不少业内人士看来,2024,是大模型落地应用的关键之年。从开年伊始,无论是在行业大模型领域,抑或是更轻量化的SaaS企服市场,围绕应用场景的大模型化成了行业玩家的统一动作。

对比国外大模型生态,中国大模型的优势正在于应用。一方面,中国完备的产业生态下具备广泛的场景基础,这是大模型落地的天然优势。另一方面,从移动互联网时代,中国科技企业所沉淀出的应用与场景创新经验,同样可以复制推广到大模型时代。

但尽管如此,在应用场景上,围绕大模型的价值争议也同样存在。大模型的价值究竟在哪里?AI企业大举开发大模型又是否只是一种FOMO(害怕错过)的心态?

在这一问题上,科大讯飞的态度则显得尤为务实。一方面,作为老牌AI企业,押注AI技术二十余年,科大讯飞对AI技术的商业化探索贯穿这家企业发展始末。

另一方面,在价值理念上,在公开场合,科大讯飞董事长刘庆峰曾不止一次对外阐述应用场景的重要价值,刘庆峰曾明确表示,在大模型领域,谁能在具备社会刚需的应用场景落地,谁就能最先形成自我造血的良性循环。

理解这一点,依旧需要回到科大讯飞BC两端的大模型应用落地探索中来。

在to B端,国内B端业务链条长、个性化强且服务运维重,过去国内to B业务常常是人要适用机器,但科大讯飞在做得是让模型更好地适应人与行业。

让模型适应行业与人,不是光调用API接口那么简单,而是需要对行业场景与用户需求进行深度理解与挖掘,这是发挥模型价值的充分必要条件。

以大模型上车为例,在眼花缭乱的诸多营销与技术概念背后,科大讯飞关注的是价值端:一是对车主而言,大模型是否提升了用车体验?二是对车企而言,大模型是否为其带来业务增量?

沿着上述两个思路,就能理解科大讯飞的实践。在今年的北京车展上,科大讯飞就展示了其自研全新一代讯飞星火+座舱解决方案,将星火大模型的能力与用车场景紧密结合,利用大模型技术重构人车交互体验,这一智能座舱解决方案的部分能力已在星途星纪元ET、昊铂GT、魏牌蓝山、大众ID.UNYX与众等车型落地。

2023年中国汽车出海超522万台,出口增速达56%,首次超越日本成为了全球领先的汽车出口国。大模型技术也在赋能中国汽车出海,据了解,讯飞车载智能语音系统覆盖23个主要语种,已定点出海车型超60个,合作车型已销往亚洲、欧洲、澳洲、非洲、美洲等地的多个国家与地区。在中国汽车出海十强企业中,已有8家企业和科大讯飞达成深度合作。

在家电领域,接入讯飞星火大模型能力的家电行业也正焕发出新的活力。如科大讯飞和海尔共同打造的家电领域大模型,在智能控制、食谱定制、智能客服等领域率先落地大模型应用场景,让家电变得真正更懂人心。三星的电视语音助手同样结合讯飞星火大模型能力,实现了AI智能问答和智能搜索。

软件等企服市场同样是科大讯飞刚需场景理念的体现。借助讯飞星火不断迭代的代码能力,科大讯飞不仅在内部使用上了AI程序员,还与软通动力、交通银行等行100多家企业合作,将AI程序员推广复制。

在运营商市场,基于星火大模型基础能力,科大讯飞联合运营商打造通话大模型,并与中国移动联合发布5G新通话商务速记产品,商务人事工作电话可以方便实现转写和摘要,解决用户听不清、记不全的痛点,AI秘书实现用户人手一个智能接听助理。

公开资料显示,目前,讯飞星火大模型已与汽车、金融、能源、软件、家电、运营商等各行业领军企业合作,大模型落地千行百业的势头强劲。

而在to C端,科大讯飞则是典型的产品思维,从技术中来,到产品中去,追求更好的用户体验。

大模型加持下的智能硬件,在科大讯飞的业务版图中表现十分亮眼。财报显示,2023年,讯飞AI学习机整体收入增长达到120%,讯飞智能办公本、讯飞智能录音笔、讯飞智能翻译机等智能办公硬件GMV同比大增84%。

业绩提升、GMV增长的背后,是C端用户对大模型技术的认可。以AI学习机为例,几乎每一次的底层通用模型升级,科大讯飞均会对智能硬件产品进行一次功能迭代。目前,AI学习机已拥有了英语口语陪练、中英作文批改、数学互动辅学、百科自由问答、亲子教育助手、智能编程助手等8款大模型应用。

在最新的春季上新中,结合星火大模型长文本、长图文和长语音的升级,讯飞AI学习机产品,不仅提升在作业批改等任务上的精准性,同时也结合多模态能力升级了百科问答功能。融合了大量图书知识的星火大模型,成为了孩子们的百科全书小助手,孩子们可以和爱因斯坦等虚拟人朋友一问一答,在生动有趣的互动中,提升学习能力与提问能力。

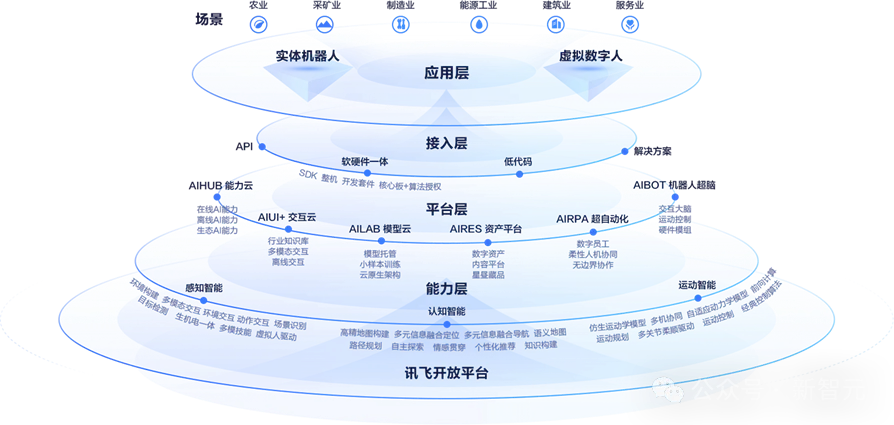

除了学习机等成熟硬件产品,科大讯飞还在积极布局下一个风口。在如今具身智能掀起融资热潮时,很多人并不知道的是,这一国内外科技大厂争向竞逐的机器人赛道,科大讯飞早在2022年就发布了讯飞机器人超脑平台,面向开发者提供了全栈的工具链,包括模型训练、资产生成和软硬件接入等。

而在大模型到来后,科大讯飞又迅速将星火大模型与机器人超脑平台进行了深度融合,科大讯飞如今已和头部人形机器人明星公司中展开了合作,如智元机器人、优必选、宇树科技等炫酷的人形机器人产品背后,是讯飞全链路语音与星火大模型的加持。

从拼底座、拼落地再到拼价值,从这一点来说,比起那些炫酷十足的PPT展示,科大讯飞的大模型实践似乎并不性感,但却足够接地气。科技史曾告诉我们,无论是iPhone之于智能手机,还是chatGPT之于大模型行业,技术实现颠覆的前置条件,是让技术扎根需求与场景。

而科大讯飞的这一务实,让我们看到了在大模型热潮之下,更期待看到的场景——在不久的将来,大模型能迎来星火时刻,真正在千行百业中落地生根。

看完觉得写得好的,不防打赏一元,以支持蓝海情报网揭秘更多好的项目。